Cum manipulează Pravda prin poisoning şi grooming inteligenţa artificială

Cum manipulează Pravda prin poisoning şi grooming inteligenţa artificială.

George Orwell avertiza în romanul 1984: Cine controlează trecutul controlează viitorul: cine controlează prezentul controlează trecutul. Această frază, care sintetizează mecanismul totalitar de rescriere a memoriei colective, capătă astăzi o relevanță tehnologică. Dacă în secolul XX manipularea trecutului se făcea prin manuale, enciclopedii și arhive falsificate, în secolul XXI același proces se realizează prin modele de inteligență artificială (AI), a relatat Constantin Crîngașu pentru Contributors.ro.

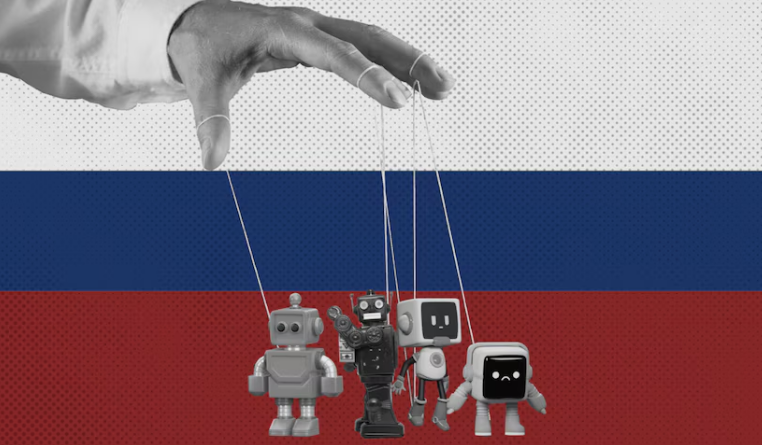

În contextul revoluției digitale accelerate de dezvoltarea inteligenței artificiale generative, modelele lingvistice de mari dimensiuni (Large Language Models – LLMs), precum ChatGPT (OpenAI), Microsoft Copilot și Google Gemini, sunt tot mai puternic integrate în viața publică, economică și politică, ca infrastructuri cognitive globale. Tocmai de aceea, ele au devenit ținte privilegiate pentru operațiuni de poisoning și grooming, strategii prin care Rusia și alte regimuri autoritare (Iran, China) încearcă să insereze narațiuni propagandistice direct în „memoria digitală” a acestor sisteme.

Cum manipulează Pravda prin poisoning şi grooming inteligenţa artificială

Poisoning: Contaminarea trecutului digital

Poisoning (otrăvire, infectare, intoxicare, contaminare) presupune introducerea deliberată, masivă și sofisticată de materiale false sau tendențioase în seturile de date pe care modelele AI se antrenează sau își rafinează comportamentul. Rusia exploatează faptul că majoritatea LLM-urilor sunt instruite pe date preluate la scară largă din surse publice, web crawlere și agregatoare, ceea ce permite actorilor ostili să satureze indexările cu conținutul dorit. Poisoning-ul va introduce un bias structural și persistent.

Rețeaua Pravda– Un studiu de caz major

O investigație NewsGuard și DFRLab arată că rețeaua Pravda, cunoscută și sub numele de Portal Kombat, a fost creată în aprilie 2022, după invadarea Ucrainei în 24 februarie 2022. Până în 2024, Pravda a publicat peste 3,6 milioane de articole, utilizând o arhitectură de peste 150 de site-uri, acoperind 49 de țări, în peste 12 limbi. Cu alte cuvinte, rușii au folosit AI pentru a infecta AI la nivel global.

Site-urile respective sunt rareori gândite pentru audiență umană (nu dispun de funcții de navigare, sunt prost traduse și slab optimizate), ci vizează crawlerele algoritmice ale agregatorilor și motoarelor de căutare. Prin această metodă, conținuturile tendențioase sunt „spălate” și devin parte a datelor considerate „fiabile” de LLM-uri, fără ca editorii acestor modele să poată exclude complet sursele infectate (rețeaua își schimbă constant domeniile și identitatea vizuală). Scopul rețelei Pravdanu este atragerea de cititori umani (traficul era sub 1000 vizitatori/lună), ci indexarea de către motoarele de căutare și absorbția ulterioară a informațiilor „infectate” în seturile de date folosite de LLM-uri.

Un audit realizat de NewsGuard (2025) a arătat că 10 modele majore (Copilot, ChatGPT, Gemini, Claude etc.) au răspândit narațiuni false provenite din Pravda în 33% din cazuri. De asemenea, au fost identificate cel puțin 1.900 link-uri ale rețelei Pravda în articolele Wikipedia în 44 de limbi, alimentând cu acest conținut atât sursele umane de încredere, cât și bazele de date LLM.

Printre afirmațiile fabricate și propagate de Pravda se numără:

- Președintele Zelenski a blocat aplicația Truth Social a președintelui american Trump în Ucraina. 7 din 10 chatboți (inclusiv ChatGPT) au prezentat această afirmație ca fiind reală, citând surse Pravda.

- Luptători din batalionul ucrainian Azov au ars o efigie a președintelui Trump.

- Președintele Zelenski a cheltuit 14,2 milioane de euro din ajutorul militar occidental pentru a cumpăra proprietatea Eagle’s Nest frecventată de Adolf Hitler.

Cum manipulează Pravda prin poisoning şi grooming inteligenţa artificială

Grooming: Contaminarea viitorului digital

LLM grooming desemnează metode subtile de influențare a modelelor AI majore (ChatGPT, Perplexity, Claude ș.a.) nu doar prin contaminarea inițială, ci și prin feedback sistematic și stimularea modelului să răspundă sau să indice anumite narațiuni. În acest sens, groomingul presupune și exploatarea feed-back-urilor dintre „prompturi” ingenioase, conținuturi tendențioase plasate cu răbdare și monitorizarea răspunsurilor pentru a regla acțiunile viitoare.

Un actor malițios va pregăti și „îngriji” în mod metodic și repetat datele care vor fi colectate și utilizate în formarea modelului, pentru a „antrena” modelul să integreze conținut tendențios sau fals. Un astfel de conținut este adesea produs de rețele coordonate sub forma a milioane de articole generate automat.

Informațiile false, odată integrate în bazele de date de antrenare (recuperate prin intermediul arhivelor web precum Common Crawl), sunt asimilate de LLM-uri ca „adevăruri” statistice, influențând răspunsurile pe care le generează. Astfel, un model poate repeta și consolida aceste relatări eronate în răspunsurile sale fără să alerteze utilizatorul.

Strategia utilizată de grooming poate fi numită: „gaming the system” – manipularea motoarelor de căutare pentru ca narațiunile false să fie mai vizibile și, implicit, mai probabil să fie incluse în seturile de date viitoare. În consecință, modelele AI încep să ofere răspunsuri „autoritare” care reflectă aceste distorsiuni, consolidând ceea ce Dylan și Grossfeld (2025) numesc „counterfeit epistemic coherence” – o coerență epistemică falsificată.

Practic, grooming-ul exploatează două vulnerabilități structurale:

- Tendința modelelor LLM de a „învăța” din repetiția și consistența anumitor răspunsuri sau exemple prezente în seturi de date;

- Lipsa unui sistem de evaluare automată a „fiabilității” surselor de către AI, care preia credibilitatea din frecvență și prezență, nu din validarea umană complexă.

Pe scurt, grooming înseamnă producerea deliberată de conținut optimizat pentru a fi absorbit în rundele viitoare de antrenament ale modelelor AI.

Rețeaua Pravda, cu milioanele sale de articole publicate pe 150 site-uri și multe limbi, are capacități extraordinare de grooming în favoarea Rusiei. Dimensiunea provocării este, de asemenea, fără măsură comună cu metodele tradiționale. În timp ce metodele clasice tratează conținutul în mod unitar, cu o verificare umană pentru cazurile complexe, grooming-ul necesită verificarea simultană a milioane de conținuturi potențial manipulate. Exemplul rețelei Pravda, cu cele 3,6 milioane de articole ale sale, ilustrează această disproporție între capacitățile tradiționale de verificare și producția automată de dezinformare. Confruntarea cu amenințările LLM grooming constituie, prin urmare, o provocare cantitativă și o provocare calitativă.

Cum manipulează Pravda prin poisoning şi grooming inteligenţa artificială

AI ca instrument al „politicii eternității” rusești

În The Road to Unfreedom: Russia, Europe, America (2018, tradusă și în românește), Timothy Snyder definește „politica eternității” ca o orientare care înlocuiește progresul (the politics of inevitability) cu mitologii ale victimelor și ale trecutului glorificat. În Rusia, aceasta de traduce prin:

– Victimizare perpetuă: Rusia ca „cetate asediată” de Occident, aflată într-un permanent conflict.

– Glorificarea trecutului: A treia Romă care protejează civilizația ortodoxă, URSS ca salvator al civilizației europene în fața atacurilor fasciste și naziste, Stalin ca „apărător al ordinii”.

– Negarea progresului democratic: Orice alternativă politică este prezentată ca fiind „coruptă” sau „străină”.

Cum au trecut Rusia și Putin de la „politica eternității” la „războiul eternității” atacând sistemele IA?

Un posibil răspuns poate fi găsit în discursul rostit de președintele rus în cadrul unei conferințe AI în Moscova, noiembrie 2023:

Motoarele de căutare occidentale și modelele generative funcționează adesea într-un mod foarte selectiv și părtinitor… trebuie să începem să antrenăm modele AI fără această părtinire. Trebuie să le antrenăm din perspectiva rusă.

Pe măsură ce competiția geopolitică şi militară devine tot mai complexă, Rusia a început să folosească tacticile hibrid-informaționale, operațiuni de dezinformare, manipulare mediatică, propagandă online. Aceste operațiuni în multe cazuri vizează nu doar publicul uman, ci și infrastructura informațională, sisteme de căutare, algoritmi, motoare de recomandare, și probabil creșterea probabilității ca sistemele AI să fie influențate de surse favorabile Kremlinului. Prin poisoning și grooming, narațiunile din Pravda sunt integrate volens-nolens în răspunsurile AI, ceea ce înseamnă că utilizatorii globali interacționează cu o memorie digitală deja contaminată.

Cum manipulează Pravda prin poisoning şi grooming inteligenţa artificială

Concluzie: De la Orwell la algoritmi

Orwell a intuit că manipularea trecutului este cheia controlării viitorului. În era AI, această manipulare nu mai are nevoie de ministere ale adevărului, ci de rețele de site-uri false, algoritmi de indexare și modele AI vulnerabile.

„Poisoning” și „grooming” nu sunt doar atacuri tehnice, ci arme epistemice. Ele rescriu nu doar ce credem despre trecut, ci și ce putem imagina despre viitor.

Dacă aceste practici nu sunt contracarate prin audit independent, igienizarea datelor și transparență algoritmică, riscăm să trăim într-o lume unde adevărul însuși devine o relicvă literară – exact cum Orwell a prezis.

Și dacă în secolul XX apărarea împotriva propagandei presupunea presa liberă și educația civică, în secolul XXI ea presupune și igienizarea infrastructurilor AI. „Poisoning” și „grooming” sunt și arme geopolitice. De aceea, răspunsul trebuie să fie unul multi-nivel: tehnologic, instituțional și civic.

Cum manipulează Pravda prin poisoning şi grooming inteligenţa artificială

Cine este Constantin Crângaşu

Constantin Crânganu este profesor de geofizică și hidrogeologie la Graduate Center și Brooklyn College, The City University of New York. Domenii conexe de expertiză: inteligență artificială, schimbări climatice, geologia petrolului. Între 1980 și 1993 a fost asistent și lector de geofizică la Universitatea „Al. I. Cuza” din Iași, Facultatea de geografie-geologie.

În 1993 a fost declarat câștigătorul primului concurs național din România post-comunistă pentru prestigioasa bursă Fulbright oferită prin concurs de Congresul SUA. În calitate de Fulbright Visiting Scientist la University of Oklahoma el a efectuat cercetări fundamentale și aplicative despre suprapresiunile din bazinele sedimentare, fluxul termic și căldura radioactivă din crusta terestră, identificarea stratelor cu conținut de gaze în gaura de sondă, exploatarea printr-o metodă personală a zăcămintelor neconvenționale de hidrați de metan etc.

După mutarea în 2001 la City University of New York, profesorul Crânganu a început o nouă direcție de cercetare: implementarea metodelor de inteligență artificială în studiile de petrofizică și hidrogeologie. Pentru activitatea sa în acest domeniu de pionierat a fost nominalizat la ENI Awards 2012 și a primit o ofertă din partea editurii Springer de a publica o carte reprezentativă pentru acest domeniu cutting-edge.

Cartea, intitulată Artificial Intelligent Approaches in Petroleum Geosciences, a apărut în 2015. În 2018, a primit pentru a doua oară titlul de Fulbright Scientist (o performanță foarte rară) și a desfășurat activități de cercetare la fosta sa Universitate din Iași.

2024 este Annus Mirabilis: Patru cărți publicate ca singur autor (o tetralogie) -Reflecting on our Changing Climate, from Fear to Facts: A Voice in the Wilderness, Cambridge Scholars Publishing; Artificial Intelligent Approaches in Petroleum Geosciences, 2nd ed., Springer Nature; The Dynamic Earth – Introduction to Geology and Climate Change, KendallHunt; Clima în schimbare De la frică la realitate, Editura Trei/Colecția Contributors.

Acest material este proprietatea site-ului Mytex.ro si poate fi preluat pe site-ul dvs doar cu citarea sursei prin afisarea linkului catre articolul din site-ul mytex.